OpenAI, znane m.in. za sprawą ChatGPT i DALL-E, Zaprezentowało oficjalnie GPT-4 – najnowszą wersje swojego modelu językowego. Technologia ta stanowi według twórców kolejny kamień milowy w rozwoju sztucznej inteligencji.

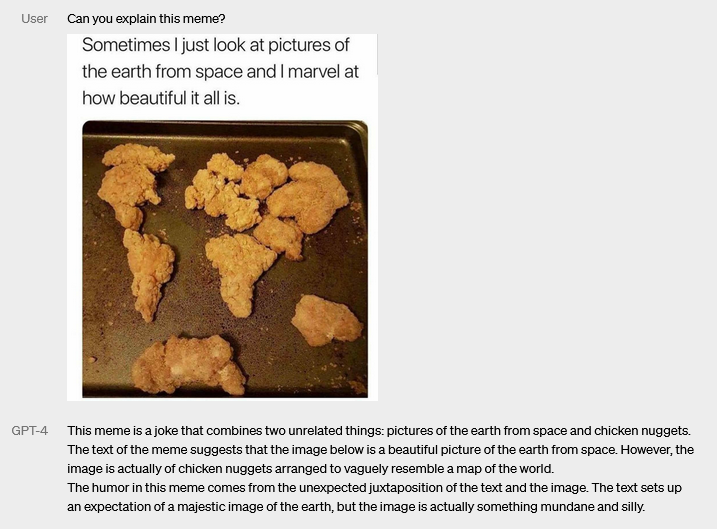

Główną cechą odróżniającą GPT-4 od poprzedniego modelu jest to, iż rozumie on już nie tylko tekst, ale też obrazy. Jego rozumienie grafiki nie ogranicza się przy tym do samego opisywania, co znajduje się na pokazanym mu zdjęciu – potrafi on też np. wyjaśnić dlaczego jest ono zabawne.

Pozostałe zmiany są już bardziej subtelne i sprowadzają się głównie do usprawniania tego, co poprzednia wersja i tak robiła już całkiem dobrze. GPT-4 ma więc lepiej rozumieć przedstawiane mu treści, być bardziej kreatywny i lepiej radzić sobie z bardziej skomplikowanymi zadaniami. Twórcy zaznaczają, że zmiany te raczej nie będą zauważalne przy typowych rozmowach, jednak wychodzą na wierzch przy nieco poważniejszych zadaniach. Jako przykład podali symulowane egzaminy prawnicze, w których udział wzięły GPT-4 i GPT-3.5. Nowszy model znalazł się w 10% najwyższych wyników, zaś starszy w 10% najsłabszych.

OpenAI zastrzega, że mimo wszystkich usprawnień GPT-4 nadal potrafi mylić się, popełniać błędy a czasami wręcz zmyślać informacje (co twórcy zgrabnie określają jako jego „halucynacje”), dlatego też należy zachować ostrożność przy wykorzystywaniu treści generowanych przez ten model. Twórcy wprowadzili też dodatkowe zabezpieczenia, dzięki którym ma być jeszcze trudniej zmusić GPT-4 do wypowiadania się na zakazane tematy (np. udzielanie porad związanych z działalnością przestępczą).

GPT-4 jest już wykorzystywany przez Microsoft w wyszukiwarce Bing i przeglądarce Edge. Dostęp do nowej technologi mają też subskrybenci usługi ChatGPT Plus. Warto jednak zaznaczyć, że funkcja rozpoznawania obrazu nie jest jeszcze dostępna. Ma ona jednak zostać wprowadzona już niedługo.

Źródło: OpenAI